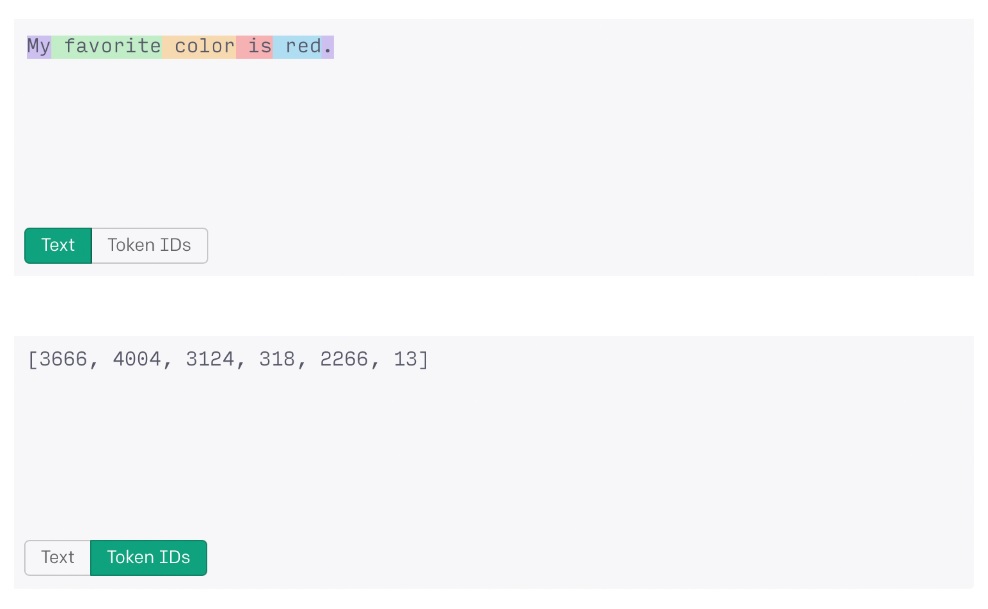

Токенизация — одна из главных проблем текущего поколения языковых моделей по типу ChatGPT. Каждому слову в запросе пользователя присваивается токен, который впоследствии будет обработан системой. Их количество ограничено. Для GPT-3.5 этот лимит составляет примерно 4 000 токенов или 3 000 слов, в то время как GPT-4 достигает максимума в 32 000 токенов или около 24 000 слов.

Новая система, предложенная разработчиками Meta* предлагает совершенно иной подход к обработке информации. В основу решения компании легла многоуровневая архитектура прогнозирования, способная моделировать более 1 миллиона байт данных.

Большинство стандартных систем кодирования на английском языке использует стандартное 8-битное кодирование, в котором каждый символ занимает один байт данных. Таким образом, система искусственного интеллекта, способная обрабатывать 1 миллион байт информации без токенизации, сможет работать с текстовыми документами, содержащими 750 000 слов, что на 3025%, чем ограничения актуальной версии GPT-4.

Переводя это на более простой язык, GPT-4 в настоящее время способен обработать около 10 коротких новостей в рамках одного запроса, в то время как Megabyte сможет целиком прочесть «Войну и мир» и еще несколько романов средней длины, а затем выдать осмысленный ответ на основе этой информации.

Модель Meta* также хорошо справляется с обработкой аудио- и видеофайлов, равняясь с моделью Perciever AR от DeepMind, и используя при этом лишь половину своей мощности.

Это исследование может серьезно поменять индустрию искусственного интеллекта. Токенизация считается главным препятствием в этой области из-за ограничений на объем вводимых данных и количества энергии и времени, необходимых для обучения систем.

Без токенизации можно будет обучать модели ИИ с более глубокой поддержкой иностранных языков, особенно тех, которые сложно закодировать в стандартные 8-битные символы. На данный момент большая часть GPT ориентирована на англоязычную аудиторию.

Помимо этого, Megabyte может улучшить показатели таких моделей, как ChatGPT, особенно в области работы с медиафайлами. Внедрение системы позволит языковым моделям генерировать видео и аудио за считанные секунды, не затрачивая на это больше сил, чем на создание текстового ответа.

*Деятельность Meta Platforms признана экстремистской на территории РФ и запрещена.

Фото на обложке сгенерировала нейросеть Midjourney.

У вас есть новость для редакции?

Напишите нам на [email protected]

Вы хотите сами размещать материалы для обсуждения?

Добро пожаловать в наше

Web3-комьюнити авторов.